自动化技术的最新进展引人瞩目,其中一项引人注目的技术是Self-Operating Computer框架。这一框架采用了先进的GPT-4V模型,通过模拟人类的鼠标点击和键盘输入,实现了令人惊叹的自主操作。在演示中,我们看到了框架自动打开浏览器并访问Google Doc,然后开始撰写诗歌。

Self-Operating Computer的核心能力在于基于给定的目标,估计鼠标点击的正确X和Y坐标位置,以及在每个步骤中进行适当的键盘输入。这一创新的框架旨在与任何视觉-文本多模态模型协同工作,以评估其操作计算机的能力。其使用GPT-4V的强大模拟功能使得计算机可以自主执行各种任务,展现了令人惊叹的智能水平。

自操作计算机框架

使多模态模型能够操作计算机的框架。

使用与人类操作员相同的输入和输出,模型查看屏幕并决定一系列鼠标和键盘操作以达到目标。

兼容性:专为各种多模式模型而设计。

集成:目前与 GPT-4v、Gemini Pro Vision、Claude 3 和 LLaVa 集成。

未来计划:支持其他型号。

在 HyperwriteAI,我们正在开发 Agent-1-Vision,这是一种多模式模型,具有更准确的点击位置预测。

我们很快将提供对 Agent-1-Vision 模型的 API 访问。

如果您有兴趣访问此 API,请在此处注册。

演示

安装项目

pip install self-operating-computer

运行项目

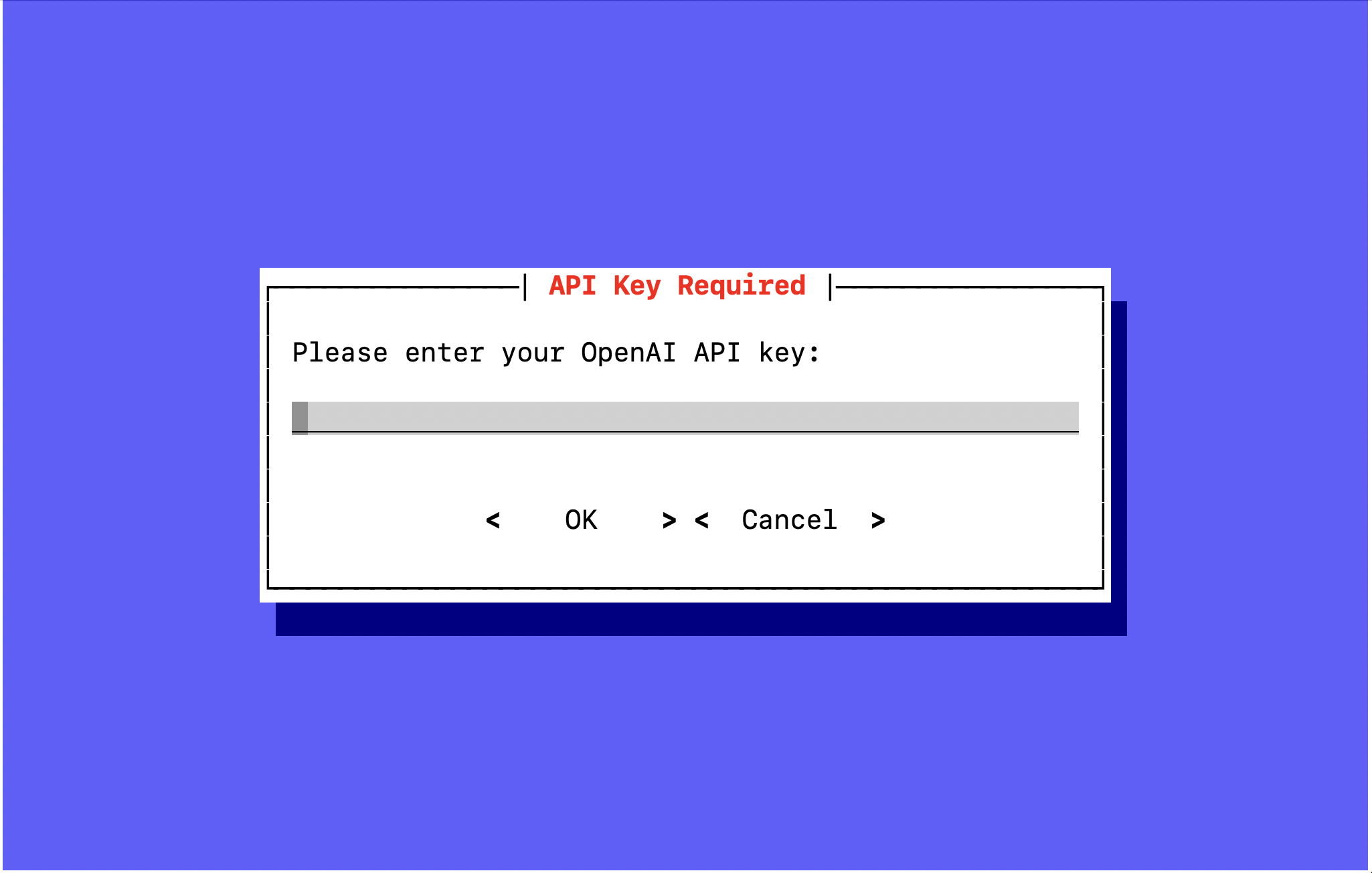

operate

输入您的 OpenAI 密钥:如果您没有密钥,可以在此处获取 OpenAI 密钥

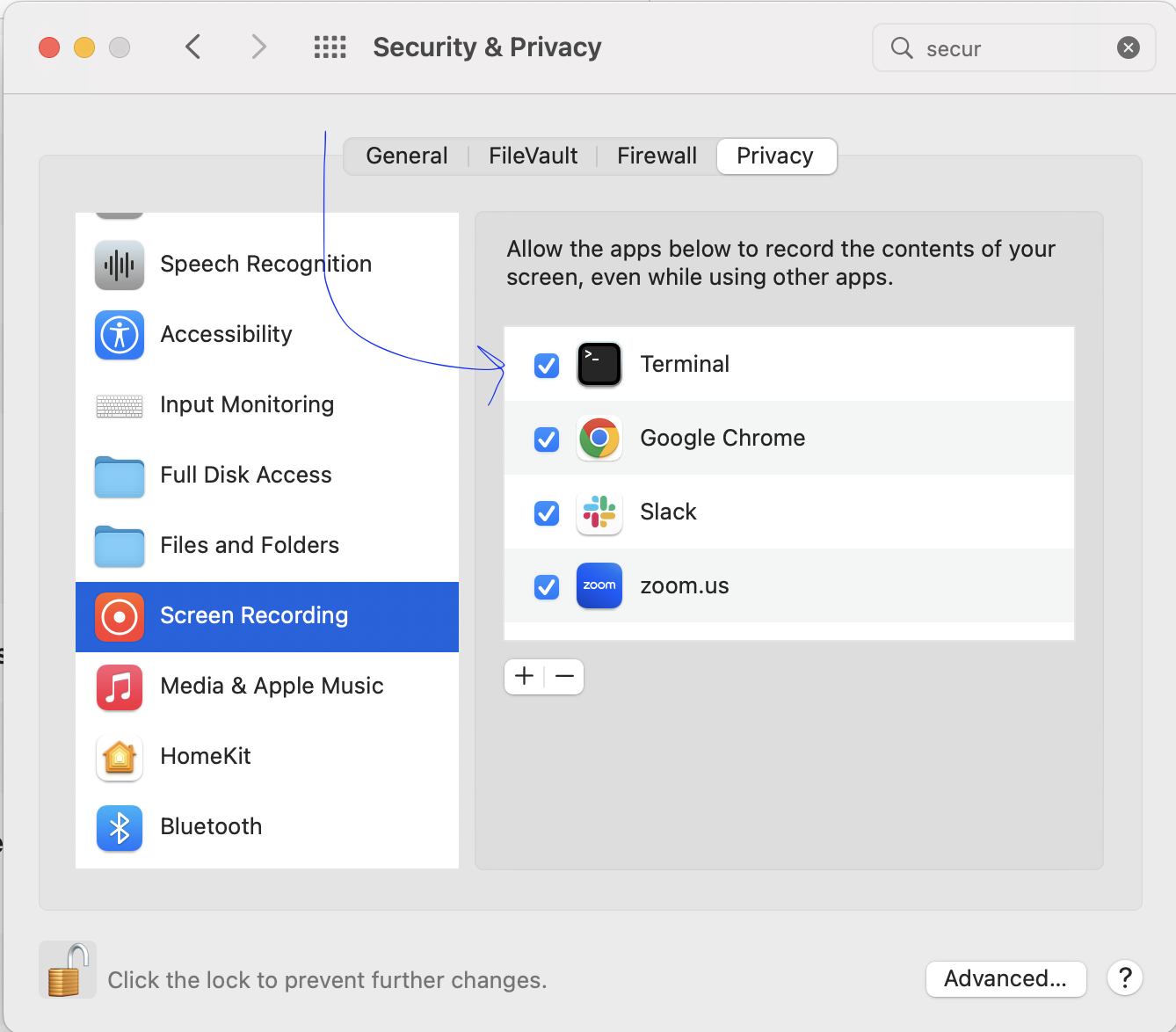

为终端应用程序提供所需的权限:作为最后一步,终端应用程序将在Mac的“系统偏好设置”的“安全和隐私”页面中请求“屏幕录制”和“辅助功能”的权限。

另一个模型现在与自操作计算机框架兼容。按照以下说明尝试 Google。gemini-pro-vision

从双子座模型开始operate

operate -m gemini-pro-vision

当终端提示您输入您的 Google AI Studio API 密钥时如果您没有密钥,可以在设置 Google AI Studio 帐户后在此处获取密钥。您可能还需要桌面应用程序的授权凭据。我花了一点时间让它工作,如果有人知道更简单的方法,请做一个 PR。

将 Claude 3 与 Vision 一起使用,看看它在操作计算机时如何与 GPT-4-Vision 相提并论。导航到 Claude 仪表板以获取 API 密钥,然后运行以下命令进行尝试。

operate -m claude-3

如果您想在自己的机器上使用 LLaVA 试验自操作计算机框架,您可以使用 Ollama!

注意:Ollama 目前仅支持 MacOS 和 Linux

首先,从 https://ollama.ai/download 在您的机器上安装 Ollama。

安装 Ollama 后,拉取 LLaVA 模型:

ollama pull llava

这将在您的计算机上下载模型,这需要大约 5 GB 的存储空间。

当 Ollama 完成拉取 LLaVA 后,启动服务器:

ollama serve

就是这样!现在开始并选择 LLaVA 模型:operate

operate -m llava

重要:使用 LLaVA 时的错误率非常高。这只是为了作为一个基础,随着本地多模式模型的改进而建立。

在 GitHub 存储库中了解有关 Ollama 的更多信息

该框架支持目标的语音输入。按照以下说明尝试语音。将存储库克隆到计算机上的目录:

git clone https://github.com/OthersideAI/self-operating-computer.git

Cd 进入目录:

cd self-operating-computer

安装额外的requirements-audio.txt

pip install -r requirements-audio.txt

安装设备要求对于Mac用户:

brew install portaudio

对于 Linux 用户:

sudo apt install portaudio19-dev python3-pyaudio

以语音模式运行

operate --voice

自操作计算机框架现在将光学字符识别 (OCR) 功能与该模式集成在一起。此模式为 GPT-4 提供了按坐标排列的可点击元素的哈希图。GPT-4 可以通过文本决定元素,然后代码引用哈希图来获取 GPT-4 想要点击的元素的坐标。gpt-4-with-ocrclick

根据最近的测试,OCR 的性能优于普通 GPT-4,因此我们将其设置为项目的默认值。要使用 OCR 模式,您只需编写:som

operate或者也可以工作。operate -m gpt-4-with-ocr

自操作计算机框架现在支持使用命令进行标记集 (SoM) 提示。这种新的视觉提示方法增强了大型多模态模型的视觉接地能力。gpt-4-with-som

在详细的arXiv论文中了解有关SoM提示的更多信息:此处。

对于此初始版本,训练了一个简单的 YOLOv8 模型用于按钮检测,该文件包含在 .鼓励用户交换其文件以评估性能改进。如果您的模型优于现有模型,请通过创建拉取请求 (PR) 来做出贡献。best.ptmodel/weights/best.pt

从 SoM 模型开始operate

operate -m gpt-4-with-som

如果您想自己做出贡献,请参阅 CONTRIBUTING.md。

有关改进此项目的任何意见,请随时在 Twitter 上联系 Josh。

如需实时讨论和社区支持,请加入我们的 Discord 服务器。

如果您已经是会员,请在 #self-operating-computer 中加入讨论。

如果您是新手,请先加入我们的 Discord 服务器,然后导航到 #self 操作计算机。

随时了解最新进展:

此项目与 Mac OS、Windows 和 Linux(安装了 X 服务器)兼容。

该模型是必需的。要解锁对此模型的访问权限,您的帐户需要花费至少 5 美元的 API 积分。如果您尚未花费最低 5 美元,预付这些积分将解锁访问权限。

点击此处了解更多信息gpt-4-vision-preview

资源库 » 解放双手 自主操作计算机框架Self-Operating Computer:用GPT-4V来模拟人类的鼠标点击和键盘输入